La présentation d’ALM 11 était plutôt intéressante j’avoue. Une grande messe avec son lot de nouveautés, de discours roboratif, de partenaires avides de visibilité, le tout dans la sauce corporate habituelle.

Introduction de la communication

Mais l’impression générale est très positive pour mon ressenti. Je vous laisse donc à votre appétit gourmand de testeur et bonne lecture.

Je vous présente cela par ordre d’apparition à « l’écran »…

La chargé de communication HP monte sur la scène et « blabla… merci… blabla… ». La chose à retenir étant la présence des partenaires comme Sogeti, Stéria, Atos Origin pour les industriels des tests. Mais aussi des sociétés comme Dalisys, Open, ValidIT ou C2L2 consulting pour les challengers en devenir. Et enfin Cognizant souhaitant finir d’établir sa tête de pont testing en France.

Hélas leurs présences ne se sont réalisées que sous forme de plaquette disponible sur des présentoirs (certains partenaires ont même osés des plaquettes bricolées et imprimées surement sur des imprimantes 9 aiguilles… Qu’il est bon de rire parfois).

Introduction du DG HP France – Bruno Buffenoir

Le DG de HP France monte sur la scène et tente d’aborder le test et ALM 11 en partant de la génération Y et leurs besoins en agile, mobilité, Web 2.0, réseaux sociaux, les cycles courts, etc. Hum… pourquoi pas mais la ficelle « On trouve un sujet sexy et teasing pour introduire ALM » était trop visible et surtout sans rapport flagrant avec le sujet. Bref, HP s’est fait plaisir mais nous on patienté en attendant.

Ensuite un passage par les nouveaux enjeux pour le SI qui était cette fois dans le vif du sujet enfin. Le paradigme de HP étant d’évoquer le concept de « Supply chain IT » !

Le concept peu clair à l’oral, s’éclairci en lisant les slides (reçu récemment). En fait la supply chain IT est ce qui fait le lien et assure le support entre les utilisateurs (clients, employés, etc.) et le SI d’une entreprise (processus, applications, etc.). Concept nouveau pour moi j’avoue et qui ouvre quelques perspectives intéressantes pour le futur.

Après la supply chain IT, on arrive aux nouvelles tendances comme le mobile computing, le cloud (private ou pas), la virtualization, et l’ALM ou Application Lifecycle Management.

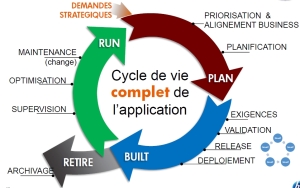

L’ALM est donc décrit sous la forme du processus run > plan > built > retire

L’enchainement est fait sur l’intégration de bout en bout de la qualité, de la sécurité et des performances des SI.

Enfin, la conclusion est faite en mettant en évidence l’ALM et la supply chain IT.

Présentation d’ALM par Yrieix Garnier –Directeur de produit HP

Intérêt de son intervention ? En triant dans ce qu’il a pu dire on peut remarquer les points suivants :

Implémentation d’HP ALM 11

HP ALM 11 était présenté comme la plateforme JAZZ d’IBM RATIONAL (slide presque identique que chez IBM) !

Ok, après avoir bien rigolé notons tout de même qu’autour d’HP ALM 11, présenté comme « référentiel unique, plateforme unifiée », sont intégré les applications / Fonctions suivantes :

- HP Sprinter pour les tests « manuels »

- Quality Center 11 – Functionnal Test Engineer

- ALM 11 – Project Manager (étrange ALM 11 est présenté pourtant comme la plateforme…)

- PC 11 / LoadRunner 11 – Performance Engineer

- ASC + Fortify – ASC étant l’ex-module tests de sécurité

- RM 11 + Business Process Management – Biz Analyst

En transverses du tout la tracabilité est présentée comme de bout en bout. A vérifier donc.

En support les “outils” developer MSVS, developer .NET et developer Java.

Intégration et collaboration

En plus de la plateforme ALM 11 les environnements (ou framework) comme Eclipse, MS Visual Studio et Collabnet sont intégrés. Ceci avec des accès direct aux éléments comme ALM / QC depuis l’IDE Eclipse, les exigences, le module defect, etc.

Et le tout avec la traçabilité assurée et une synchronisation bi-directionnelle.

Plus largement, le discours était très orienté « Pensons aux développeurs, à leurs besoins et tentons de les impliquer plus largement dans la qualité ».

Ce qui me semble une démarche saine et pleine de pertinence. Reste à voir le degré d’appropriation des communautés des développeurs dans quelques mois.

Présentation des avant-vente Olivier Jean, Jean-Luc Malvoisin et Mohamed Zouari

Ce fut le clou de la matinée car ils ont su nous expliquer ALM 11 avec des mots de tous les jours et sans le discours corporate classique. Merci à eux.

Quelques chiffres afin d’épater :

- 1 plateforme unifiée

- 8 nouvelles versions d’applications

o HP ALM 11, HP Quality Center 11, HP Performance Center 11, HP Sprinter, HP Loadrunner 11, HP Functional Testing 11, Test Data Management 1.1 et HP Service Test 11

- 50 dépôts de brevets

o Sur l’Ajax Truclient et HP Sprinter notamment

- 100 nouvelles fonctionnalités

De quoi faire saliver ;- )

Avant de rentrer dans les démonstrations, une explication sur les noms a été faite, précision utile :

- Quality Center Entreprise 10 devient => Quality Center Entreprise 11

- Quality Center Premier 10 devient => HP Application Lifecycle Management 11

- Performance Center 9.5 devient => HP Performance Center 11

S’ensuit quatre démonstrations sur les points suivants :

- Planification, suivi et rapports

- Processus métier et gestion des exigences

- Accélération de l’exécution des tests – Intégration développement

- Validation de la performance sur la plateforme unifiée ALM

Les démonstrations on eu lieu sous forme de jeu de rôle de type « (DSI parle) Mais dis moi, on me signale des soucis dans notre SI ! ». Scène totalement improbable pour un DSI mais qui a eu le mérite de mettre de la vie dans ces démonstrations en nous présentant les nouveautés. Merci les avant-vente !

Pour plus de détails vous pouvez consulter les articles sur les points suivants :

- ALM 11, les processus métiers et les exigences ?

- ALM 11 et HP Sprinter ?

- ALM 11 et les pilotages des tests ?

- ALM 11 et les tests techniques – LoadRunner ?

- Présentation d’ALM 11 / Quality Center 11.00